近日,我院顾晶晶教授团队的研究成果,题为“Exploring and Mitigating Failure Behavior of Large Language Model Training Workloads in HPC Systems”的论文被计算机体系结构领域顶会议SC'25(Supercomputing,CCF-A类)录用。论文第一作者为2023级博士生俞鹏飞,论文指导老师为顾晶晶教授(通讯作者),韩皓教授、申大忠副教授,其余作者包含博士生文宝、刘阳。我校为所有作者的唯一单位,同时这是我校作为第一单位被该会议接收的首篇文章。

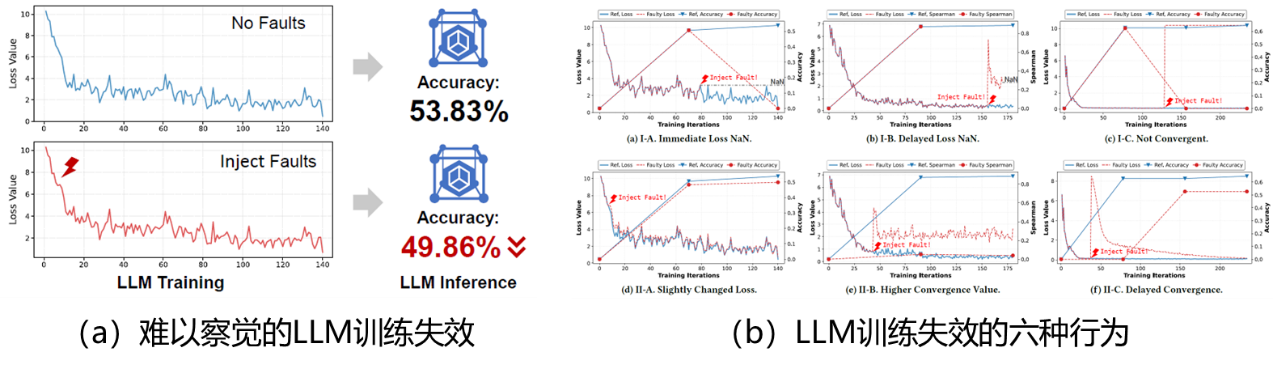

大语言模型(LLM)在高性能计算机上训练时,系统硬件偶尔会出现难以察觉的故障(如机器码0→1或1→0的翻转),这可能导致训练最终失败或者模型性能变差,从而浪费昂贵的计算资源。为了探索这一问题的机理,该项研究通过 >30万次的故障模拟实验(消耗超5千A800 GPU卡时),揭示了LLM训练的六种关键失效行为,如图1所示。论文中还提出面向LLM训练的专用轻量级容错框架LLMFT,可以在LLM训练过程中实时诊断潜在故障并自动进行修复。该框架在GPT2/Llama/Qwen等主流LLM训练负载中验证,以极低的内存开销(不到0.05%)实现接近满分的防护(故障检测平均F1-score为97.61%,检出的故障可以100%恢复)。

图1. LLM训练失效问题

SC是国际公认的计算机系统结构与高性能计算旗舰会议,也是CCF认定的A类会议,在学术界和工业界都具有较高影响力。该会议由ACM和IEEE合办,2024年有超过两万相关领域人士参会,但论文收稿量在一百篇左右。此外,近年来,国际高性能计算应用领域最高奖——戈登·贝尔奖均在SC会议上颁发,用于表彰世界范围内在科学、工程和大规模数据分析领域的创新工作。